xRやメタバースなどへの注目が高まる中、広告領域でも新たなテクノロジー活用の可能性が広がっている。CGなどによるリアルタイム表現のR&Dに多数取り組んできた岡田太一さんが解説する。

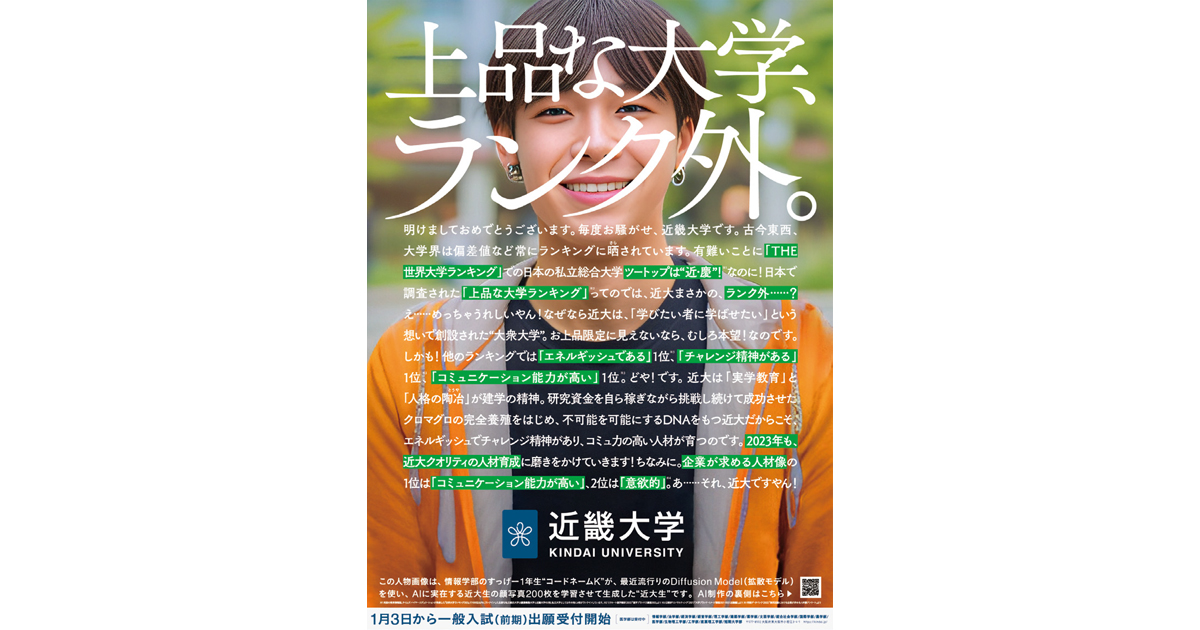

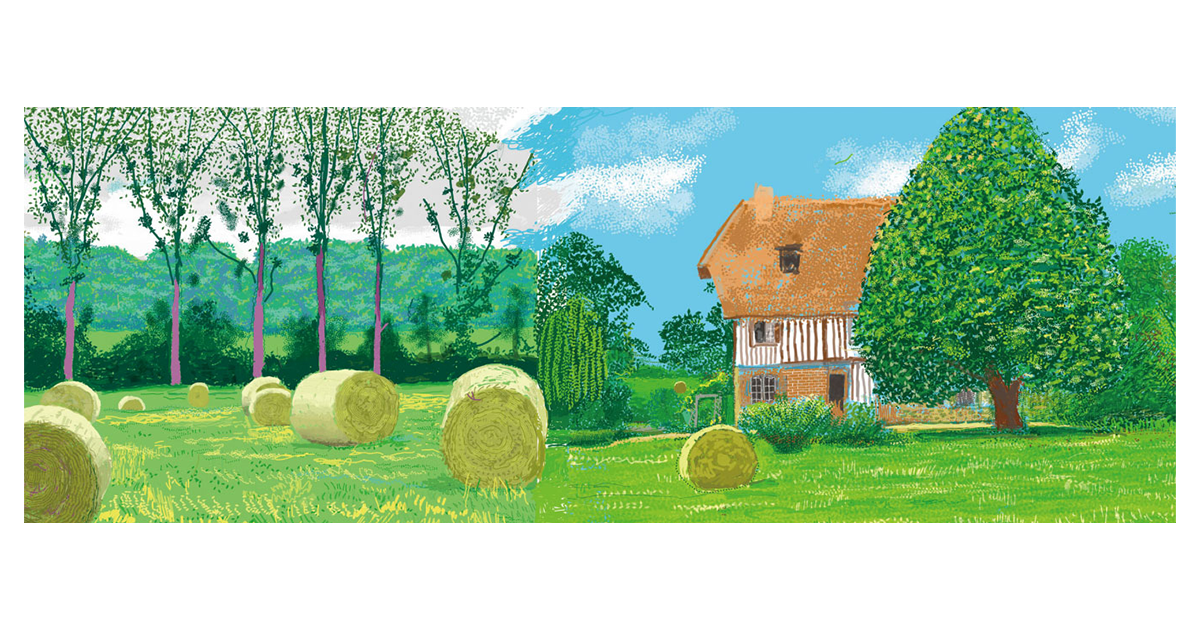

Stable Diffusion(筆者の会社のカスタムモデル)による作例。

前回まではMidjourneyとDALL・E2の変遷をご紹介しました。今回は真打ち、「Stable Diffusion」についてです。Stable DiffusionはイギリスのStability AI、ドイツのミュンヘン大学、アメリカのRunway社が共同で2022年8月にリリースした画像生成AIです。2022年のMVPと言っていいでしょう。

それまでのAI研究では論文こそ公開されるものの、トレーニング済みモデルは非公開というのが通例でした。StableDiffusionはそうした流れに逆らい、トレーニング済みモデルを一般に公開しました。これは控えめに言っても革命であり、Stable Diffusion以前、以後では世界の見え方が変わったと言えます。それまでのAIの研究スピードを「日進月歩」とたとえるなら、Stable Diffusion以後は「秒進分歩」と言って差し支えないレベルにまで研究が加速しました。

Stable Diffusionは、非営利団体であるLAIONが公開するデータセットを用いてトレーニングされています。LAIONのデータセットはいくつかあるのですが、Stable Diffusionではaesthetic scoreと呼ばれる画像の美しさのスコアなどを元に、約23億のデータを抽出して利用しています(※1)。

こうした大規模なデータセットによるトレーニングは、これまで一部の大企業にしか行えないものでしたが、GPUとクラウドの進歩により、現実的なコストで行えるようになってきました。一説には初期のStable Diffusionの...